Pourquoi reconnaître automatiquement des photos de plantes demandera encore un gros travail….

Malgré les progrès dans l’algorithmique et l’évolution de la puissance des machines, le domaine de la reconnaissance d’images est loin d’avoir atteint la perfection.

Les ordinateurs ne reconnaissent le sujet que dans 30% à 40% des cas, nous apprend MIT News qui relate le travail d’une équipe de chercheurs (.pdf) qui a trouvé un moyen original de réfléchir au problème, à défaut de le résoudre.

Les limites de la reconnaissance d’images pourraient s’expliquer de deux manières. Soit les algorithmes sont incorrects, soit il existe un problème de Big Data : il manque trop d’informations pour que le programme puisse accomplir sa tâche.

La technique la plus utilisée dans ce domaine, nous apprend le communiqué du MIT, est le HOG (pour Histogramme de gradient orienté). Il s’agit de diviser l’image en petits carrés en général de 8 pixels de côté. Ensuite, pour chacun de ces carrés, le système assigne un “gradient”, c’est-à-dire un changement de couleur, de direction, d’orientation, etc. Pour caractériser le gradient, on utilise jusqu’à 32 variables. Et 32 variables, pour des milliers de petits carrés, ça fait vraiment beaucoup. Avec pour conséquence que les développeurs ne savent plus très bien ce que leur programme produit et sur quoi il travaille.

Au final, comme l’explique Alexei Efros, professeur associé d’informatique et d’ingénierie électrique à l’université de Berkeley : “Je pense qu’avoir une grande quantité de data est une chose importante en science informatique, mais l’effet secondaire négatif c’est que les nouveaux étudiants et chercheurs… ne regardent plus les pixels. Ils sont tellement engloutis par les data, il y a tant d’images, qu’ils les traitent comme s’il s’agissait de données boursières, ou bio-informatiques, ou n’importe quel autre type de data. Ils se contentent de regarder des graphes, des courbes, des tableaux.”

Avec pour résultat, continue en substance Efros, qu’en cas d’erreur, la seule chose que puisse faire un développeur est de regarder ses données et son code et de clamer “je ne comprend pas pourquoi ça ne marche pas !”

Voir comme un ordinateur

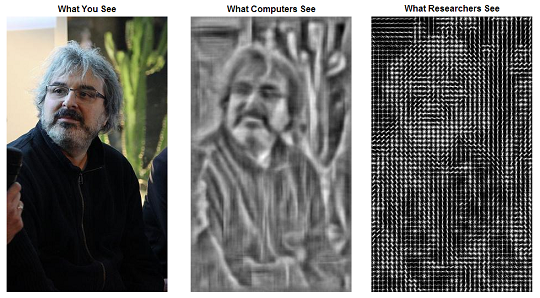

C’est là que se situe l’innovation de l’équipe du MIT. Les chercheurs se sont demandé comment les humains se débrouilleraient s’ils voyaient les mêmes images que les machines. Autrement dit, ils ont inversé le processus. Une fois l’image “préparée” et filtrée par l’algorithme HOG, ils l’ont retransformée en une illustration susceptible d’être regardée par chacun d’entre nous.

Le résultat est significatif : lorsque ces images traitées sont présentées aux spectateurs humains, ceux-ci font aussi de nombreuses erreurs, et pratiquement les mêmes que celles commises par les machines.

Le plus simple est de se rendre sur le site des expérimentateurs, où l’on trouve toute une série d’images cliquables. Par exemple, il y a toute une série de photos représentant une visualisation HOG et ressemblant, parfois de façon très claire, à un être humain. Si vous cliquez sur ces images, vous découvrirez, ô surprise, que les silhouettes humaines en question représentent en réalité toute autre chose: par exemple, la première d’entre elles semble nous montrer, de manière assez explicite, une jeune femme se tenant devant un miroir. Il s’agit en réalité d’une aile d’avion sur un fond (…)

– Voir la suite de l’article de Rémi Sussan, 24/09/13 publié sur le site internetactu.net

——————-

Photo d’illustration : Joanie Cahill, joanie on sxc.hu

1 commentaire

la chose est intéressante. Toutefois aucune indication de méthode algorithmique n’est donnée. Pour avoir travaillé sur le problème , la thermodynamique nous donne des enseignements transposables aux autres domaines et elle est puissante.